2025新澳正版資料最新 2025澳門正版免費(fèi)精準(zhǔn)大全 正版資料2025年澳門免費(fèi) 2025新澳最新版精準(zhǔn)特 2025正版資料免費(fèi)大全資料 2025年新奧正版免費(fèi)_ 2025年新奧天天開好彩 新澳門天天免費(fèi)精準(zhǔn)大全2025 澳門管家婆100%精準(zhǔn) 2025年新奧正版免費(fèi)大全 2025年天天開彩免費(fèi)資料 2025澳門天天開好彩精準(zhǔn)一碼 2025年新澳門天天開獎(jiǎng)結(jié)果查詢表 2025年澳門今晚開獎(jiǎng)號(hào)碼 新澳天天開獎(jiǎng)資料大全正版 2025澳門免費(fèi)資料,正版資料 2025精準(zhǔn)資料大全免費(fèi) 2025澳門今晚開獎(jiǎng)結(jié)果 新澳2025資料最新大全 新澳2025精準(zhǔn)正版資料 2025新澳精準(zhǔn)正版免費(fèi)資料 7777788888精準(zhǔn)一肖 2025今晚必中必開一肖 777778888精準(zhǔn)免費(fèi)四肖2025年 2025新澳門天天免費(fèi)精準(zhǔn) 777778888精準(zhǔn)免費(fèi)四肖 新澳門天天免費(fèi)精準(zhǔn) 2025新澳門天天免費(fèi)大全 新澳2025精準(zhǔn)正版免費(fèi) 澳門管家婆100%精準(zhǔn)圖片 新澳門精準(zhǔn)免費(fèi)大全 2025澳門精準(zhǔn)正版免費(fèi)四不像 2025新澳門天天開獎(jiǎng)免費(fèi) 2025新澳期期精準(zhǔn)正版免費(fèi) 澳門天天免費(fèi)精準(zhǔn)大全 7777788888精準(zhǔn)免費(fèi)4肖 奧門天天彩開正版資料 2025全年資料免費(fèi)資料 2025新澳門精準(zhǔn)免費(fèi)大全168 2025新澳天天免費(fèi)精準(zhǔn) 7777788888精準(zhǔn)三肖 2025新澳精準(zhǔn)正版免費(fèi)大全 2025年正版資料免費(fèi)大全澳門 2025年新澳門全年免費(fèi) 2025新澳門天天開獎(jiǎng)記錄圖片及價(jià)格 2025澳門天天開獎(jiǎng)大全 2025新澳門全年免費(fèi)大全 2025澳門特馬網(wǎng)站www 2025新澳正版今晚資料 2025今晚必出三肖 新2025年澳門天天開好彩 新澳2025天天開彩資料 2025新澳門天天開獎(jiǎng)記錄那澳門 澳門特馬網(wǎng)站.www 2025新澳天天開彩資料 新2025澳門天天開好彩 2025新澳門精準(zhǔn)正版圖庫(kù)

港彩高手出版精料

澳門精華區(qū)

香港精華區(qū)

- 155期:【貼身侍從】必中雙波 已公開

- 155期:【過路友人】一碼中特 已公開

- 155期:【熬出頭兒】絕殺兩肖 已公開

- 155期:【匆匆一見】穩(wěn)殺5碼 已公開

- 155期:【風(fēng)塵滿身】絕殺①尾 已公開

- 155期:【秋冬冗長(zhǎng)】禁二合數(shù) 已公開

- 155期:【三分酒意】絕殺一頭 已公開

- 155期:【最愛自己】必出24碼 已公開

- 155期:【貓三狗四】絕殺一段 已公開

- 155期:【白衫學(xué)長(zhǎng)】絕殺一肖 已公開

- 155期:【滿目河山】雙波中 已公開

- 155期:【寥若星辰】特碼3行 已公開

- 155期:【凡間來(lái)客】七尾中特 已公開

- 155期:【川島出逃】雙波中特 已公開

- 155期:【初心依舊】絕殺四肖 已公開

- 155期:【真知灼見】7肖中特 已公開

- 155期:【四虎歸山】特碼單雙 已公開

- 155期:【夜晚歸客】八肖選 已公開

- 155期:【夏日奇遇】穩(wěn)殺二尾 已公開

- 155期:【感慨人生】平特一肖 已公開

- 155期:【回憶往事】男女中特 已公開

- 155期:【瘋狂一夜】單雙中特 已公開

- 155期:【道士出山】絕殺二肖 已公開

- 155期:【相逢一笑】六肖中特 已公開

- 155期:【兩只老虎】絕殺半波 已公開

- 155期:【無(wú)地自容】絕殺三肖 已公開

- 155期:【涼亭相遇】六肖中 已公開

- 155期:【我本閑涼】穩(wěn)殺12碼 已公開

- 155期:【興趣部落】必中波色 已公開

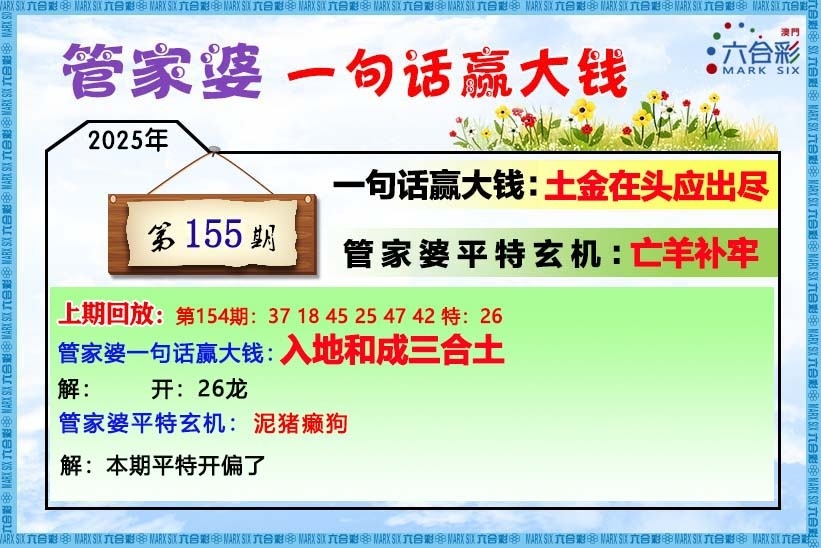

【管家婆一句話】

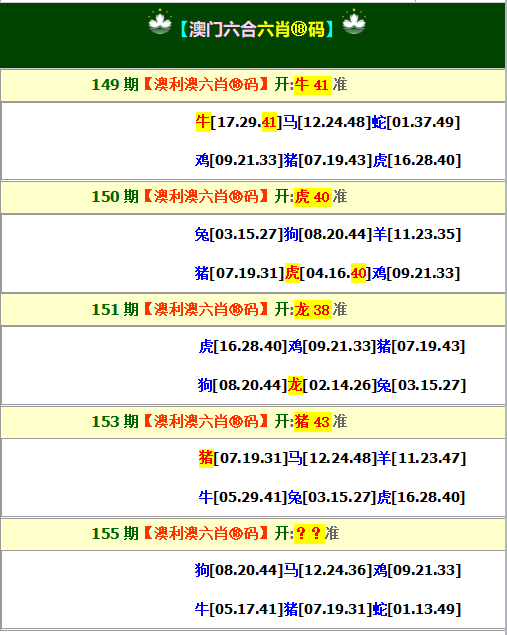

【六肖十八碼】

天天好彩【六肖中特】

天天好彩【平尾心水秘籍】

天天好彩【幽默猜測(cè)】

天天好彩澳門正版圖庫(kù)

- 澳門四不像

- 澳門傳真圖

- 澳門跑馬圖

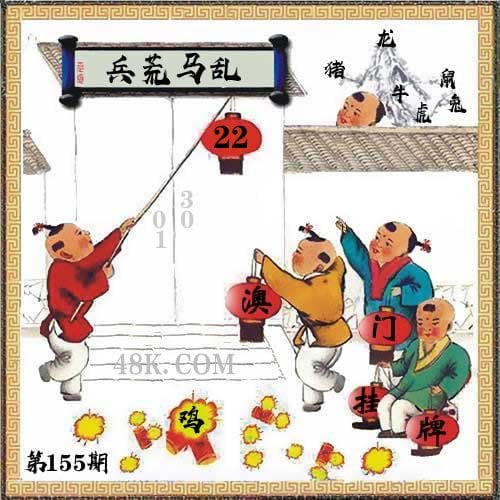

- 新掛牌彩圖

- 另版跑狗圖

- 老版跑狗圖

- 澳門玄機(jī)圖

- 玄機(jī)妙語(yǔ)圖

- 六麒麟透碼

- 平特一肖圖

- 一字解特碼

- 新特碼詩(shī)句

- 四不像玄機(jī)

- 小黃人幽默

- 新生活幽默

- 30碼中特圖

- 澳門抓碼王

- 澳門天線寶

- 澳門一樣發(fā)

- 曾道人暗語(yǔ)

- 魚躍龍門報(bào)

- 無(wú)敵豬哥報(bào)

- 特碼快遞報(bào)

- 一句真言圖

- 新圖庫(kù)禁肖

- 三怪禁肖圖

- 正版通天報(bào)

- 三八婆密報(bào)

- 博彩平特報(bào)

- 七肖中特報(bào)

- 神童透碼報(bào)

- 內(nèi)幕特肖B

- 內(nèi)幕特肖A

- 內(nèi)部傳真報(bào)

- 澳門牛頭報(bào)

- 千手觀音圖

- 夢(mèng)兒數(shù)碼報(bào)

- 六合家寶B

- 合家中寶A

- 六合簡(jiǎn)報(bào)圖

- 六合英雄報(bào)

- 澳話中有意

- 彩霸王六肖

- 馬會(huì)火燒圖

- 狼女俠客圖

- 鳳姐30碼圖

- 勁爆龍虎榜

- 管家婆密傳

- 澳門大陸仔

- 傳真八點(diǎn)料

- 波肖尾門報(bào)

- 紅姐內(nèi)幕圖

- 白小姐會(huì)員

- 白小姐密報(bào)

- 澳門大陸報(bào)

- 波肖一波中

- 莊家吃碼圖

- 發(fā)財(cái)波局報(bào)

- 36碼中特圖

- 澳門男人味

- 澳門蛇蛋圖

- 白小姐救世

- 周公玄機(jī)報(bào)

- 值日生肖圖

- 鳳凰卜封圖

- 騰算策略報(bào)

- 看圖抓碼圖

- 神奇八卦圖

- 新趣味幽默

- 澳門老人報(bào)

- 澳門女財(cái)神

- 澳門青龍報(bào)

- 財(cái)神玄機(jī)報(bào)

- 內(nèi)幕傳真圖

- 每日閑情圖

- 澳門女人味

- 澳門簽牌圖

- 澳六合頭條

- 澳門碼頭詩(shī)

- 澳門兩肖特

- 澳門猛虎報(bào)

- 金錢豹功夫

- 看圖解特碼

- 今日閑情1

- 開心果先鋒

- 今日閑情2

- 濟(jì)公有真言

- 四組三連肖

- 金多寶傳真

- 皇道吉日?qǐng)D

- 澳幽默猜測(cè)

- 澳門紅虎圖

- 澳門七星圖

- 功夫早茶圖

- 鬼谷子爆肖

- 觀音彩碼報(bào)

- 澳門不夜城

- 掛牌平特報(bào)

- 新管家婆圖

- 鳳凰天機(jī)圖

- 賭王心水圖

- 佛祖禁肖圖

- 財(cái)神報(bào)料圖

- 二尾四碼圖

- 東成西就圖

- 12碼中特圖

- 單雙中特圖

- 八仙指路圖

- 八仙過海圖

- 正版射牌圖

- 澳門孩童報(bào)

- 通天報(bào)解碼

- 澳門熊出沒

- 鐵板神算圖